Wat zijn crawlers?

Een crawler is een programma dat gegevens en informatie van internet verzamelt door websites te bezoeken en de pagina’s te lezen. Het wordt gebruikt door zoekmachines en wordt ook wel spider genoemd. Dit programma slaat alle gegevens en de externe en interne links op in een databank. Het slaat informatie op over de inhoud van de webpagina, metatags, de titel van de webpagina en nog veel meer. Het helpt bij het indexeren van websites, het crawlt één pagina per keer door een website totdat alle pagina’s zijn geïndexeerd.

Affiliate marketing woordenlijst

Ontdek de uitgebreide affiliate marketing woordenlijst van Post Affiliate Pro, met essentiële termen zoals 301 redirect, affiliate tracking en commissies. Leer meer over SEO, PPC en e-mailmarketing om je marketingvaardigheden te verbeteren. Bezoek nu voor een diepgaand begrip van de industrie!

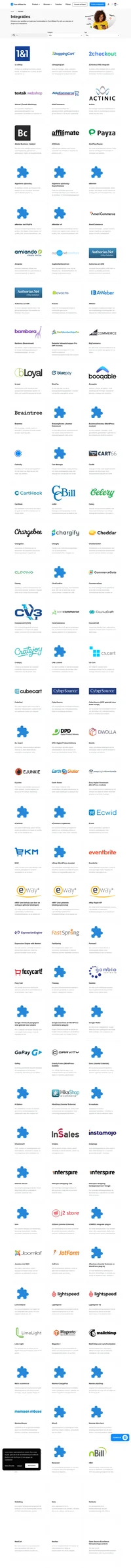

Ontdek hoe u Post Affiliate Pro kunt integreren met toonaangevende e-commerce platformen zoals 11 eShop, 1ShoppingCart, en 2Checkout voor verbeterde conversietracking en partnerrapportage. Start een gratis account en optimaliseer uw online verkoop- en marketingstrategieën eenvoudig. Bezoek nu om meer te leren over onze uitgebreide integratiemogelijkheden en begin met het vergroten van uw online succes!

Ontdek de uitgebreide Affiliate Programma Directory bij Post Affiliate Pro en verdien extra inkomsten in de media- en marketingindustrie. Verken talloze partnerprogramma's met specifieke commissiestructuren, promotiemateriaal en gratis proefperiodes van 14 dagen. Start vandaag nog en maximaliseer uw verdiensten!