Hoe werken webcrawlers? Complete technische gids

Leer hoe webcrawlers werken, van seed-URL's tot indexering. Begrijp het technische proces, de verschillende typen crawlers, robots.txt-regels en hoe crawlers SE...

Crawlers, ook wel spiders of bots genoemd, doorzoeken en indexeren systematisch het internet, waardoor zoekmachines webpagina’s kunnen begrijpen en rangschikken voor relevante zoekopdrachten.

Crawlers, ook wel spiders of bots genoemd, zijn geavanceerde geautomatiseerde softwareprogramma’s die zijn ontworpen om systematisch het enorme internet te doorzoeken en te indexeren. Hun primaire functie is om zoekmachines te helpen webpagina’s te begrijpen, te categoriseren en te rangschikken op basis van relevantie en inhoud. Dit proces is essentieel voor zoekmachines om nauwkeurige zoekresultaten aan gebruikers te leveren. Door webpagina’s continu te scannen, bouwen crawlers een uitgebreide index op die zoekmachines zoals Google gebruiken om precieze en relevante zoekresultaten te tonen.

Webcrawlers zijn in feite de ogen en oren van zoekmachines, waardoor ze kunnen zien wat er op elke webpagina staat, de inhoud begrijpen en bepalen waar de pagina in de index thuishoort. Ze beginnen met een lijst van bekende URL’s en werken deze methodisch af, analyseren de inhoud, identificeren links en voegen deze toe aan hun wachtrij voor toekomstige crawling. Dit herhalende proces stelt crawlers in staat om de structuur van het hele web in kaart te brengen, vergelijkbaar met een digitale bibliothecaris die boeken categoriseert.

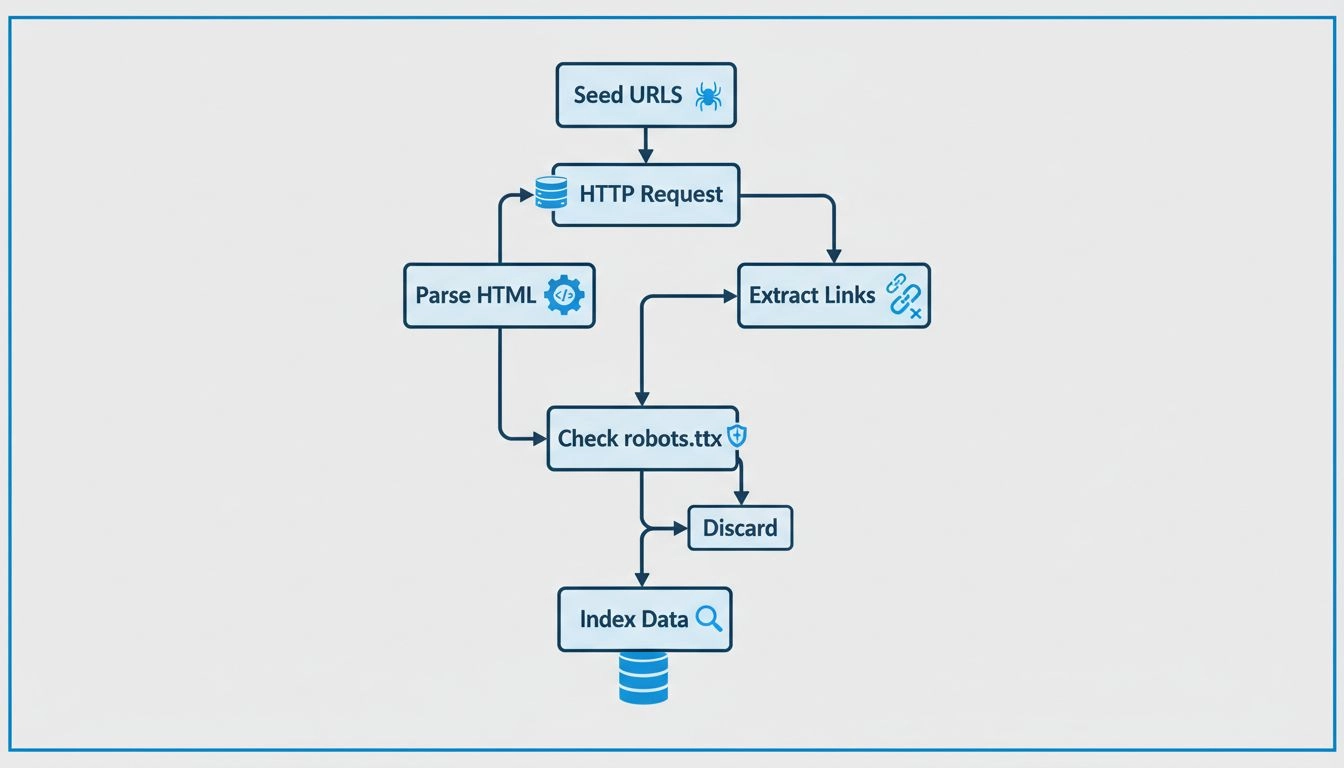

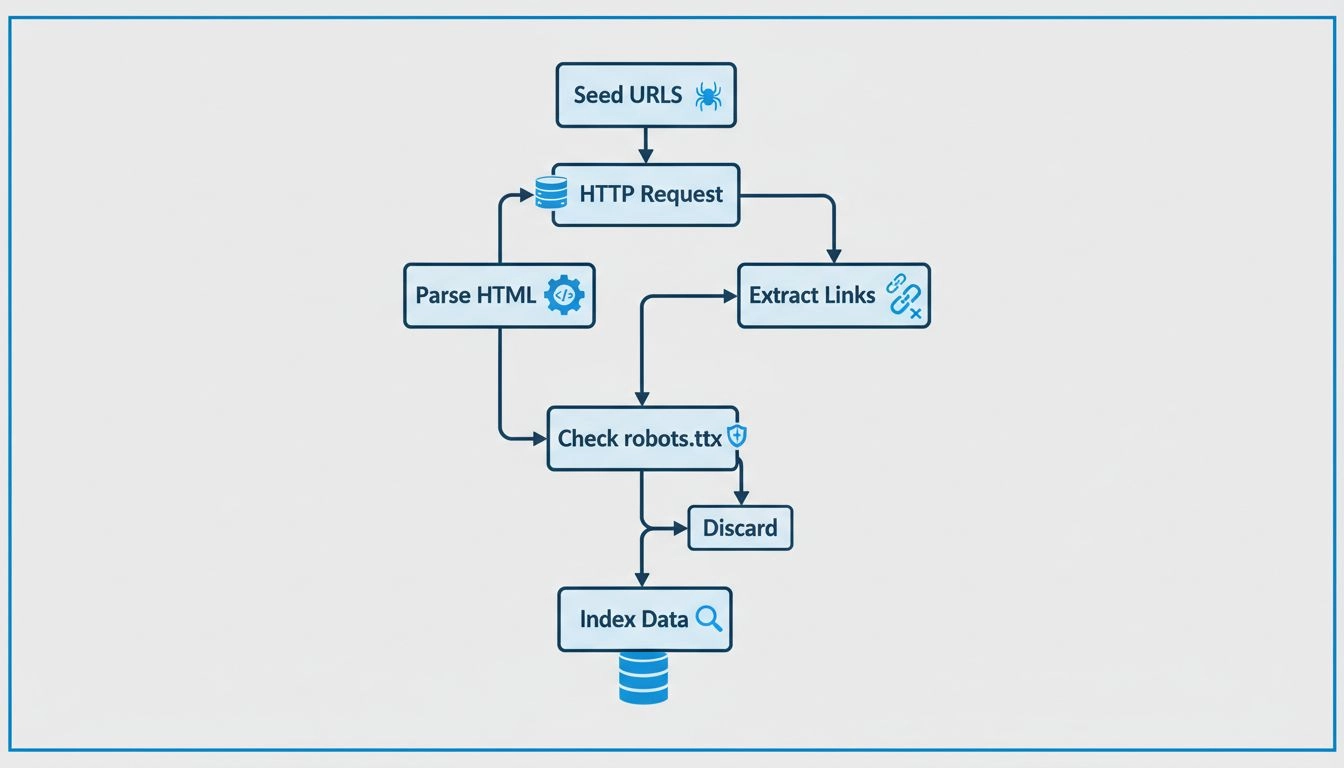

Crawlers werken door te starten met een seedlijst van URL’s die ze bezoeken en inspecteren. Terwijl ze deze webpagina’s analyseren, identificeren ze links naar andere pagina’s en voegen deze toe aan hun wachtrij voor latere crawling. Dit proces stelt hen in staat om de structuur van het web in kaart te brengen, waarbij ze links van de ene pagina naar de andere volgen, net als een digitale bibliothecaris die boeken categoriseert. De inhoud van elke pagina, inclusief tekst, afbeeldingen en meta-tags, wordt geanalyseerd en opgeslagen in een enorme index. Deze index vormt de basis waarop zoekmachines relevante informatie ophalen als reactie op gebruikersvragen.

Webcrawlers raadplegen het robots.txt-bestand van elke webpagina die ze bezoeken. Dit bestand bevat regels die aangeven welke pagina’s gecrawld mogen worden en welke genegeerd moeten worden. Na het controleren van deze regels, navigeren crawlers verder door de webpagina, waarbij ze hyperlinks volgen volgens vooraf gedefinieerd beleid, zoals het aantal links dat naar een pagina verwijst of de autoriteit van de pagina. Dit beleid helpt bij het prioriteren van welke pagina’s als eerste worden gecrawld, zodat belangrijkere of relevantere pagina’s snel worden geïndexeerd.

Tijdens het crawlen slaan deze bots de inhoud en metadata van elke pagina op. Deze informatie is cruciaal voor zoekmachines om te bepalen hoe relevant een pagina is voor een zoekopdracht. De verzamelde data wordt vervolgens geïndexeerd, zodat de zoekmachine snel pagina’s kan vinden en rangschikken wanneer een gebruiker zoekt.

Voor affiliate marketeers , is het begrijpen van de werking van crawlers essentieel om hun websites te optimaliseren en hun zoekmachineranking te verbeteren. Effectieve SEO houdt in dat webcontent zo wordt gestructureerd dat deze gemakkelijk toegankelijk en begrijpelijk is voor deze bots. Belangrijke SEO-praktijken zijn onder andere:

In de context van affiliate marketing , hebben crawlers een genuanceerde rol. Enkele belangrijke aandachtspunten:

Affiliate marketeers kunnen tools zoals Google Search Console gebruiken om inzicht te krijgen in de interactie van crawlers met hun sites. Deze tools geven informatie over crawl-fouten, sitemaps en andere statistieken, zodat marketeers de crawlbaarheid en indexering van hun site kunnen verbeteren. Het monitoren van crawl-activiteit helpt problemen op te sporen die indexering kunnen belemmeren, zodat ze tijdig kunnen worden opgelost.

Geïndexeerde inhoud is essentieel voor zichtbaarheid in zoekmachines. Zonder indexering verschijnt een webpagina niet in zoekresultaten, ongeacht de relevantie voor een zoekopdracht. Voor affiliates , is het cruciaal dat hun content wordt geïndexeerd om organisch verkeer en conversies te genereren. Goede indexering zorgt ervoor dat content gevonden en correct gerangschikt kan worden.

Technische SEO draait om het optimaliseren van de infrastructuur van de website voor efficiënte crawling en indexering. Dit omvat onder andere:

Gestructureerde data: Het implementeren van gestructureerde data helpt crawlers de context van de inhoud te begrijpen, waardoor de kans op weergave in uitgebreide zoekresultaten toeneemt. Gestructureerde data biedt aanvullende informatie die de zichtbaarheid in zoekmachines verbetert.

Sitesnelheid en prestaties: Snel ladende sites worden door crawlers gewaardeerd en dragen bij aan een positieve gebruikerservaring. Een snellere website leidt vaak tot betere rankings en meer bezoekers.

Foutloze pagina’s: Het opsporen en oplossen van crawl-fouten zorgt ervoor dat alle belangrijke pagina’s toegankelijk en indexeerbaar zijn. Regelmatige audits helpen om de gezondheid van de site te behouden en de SEO-prestaties te verbeteren.

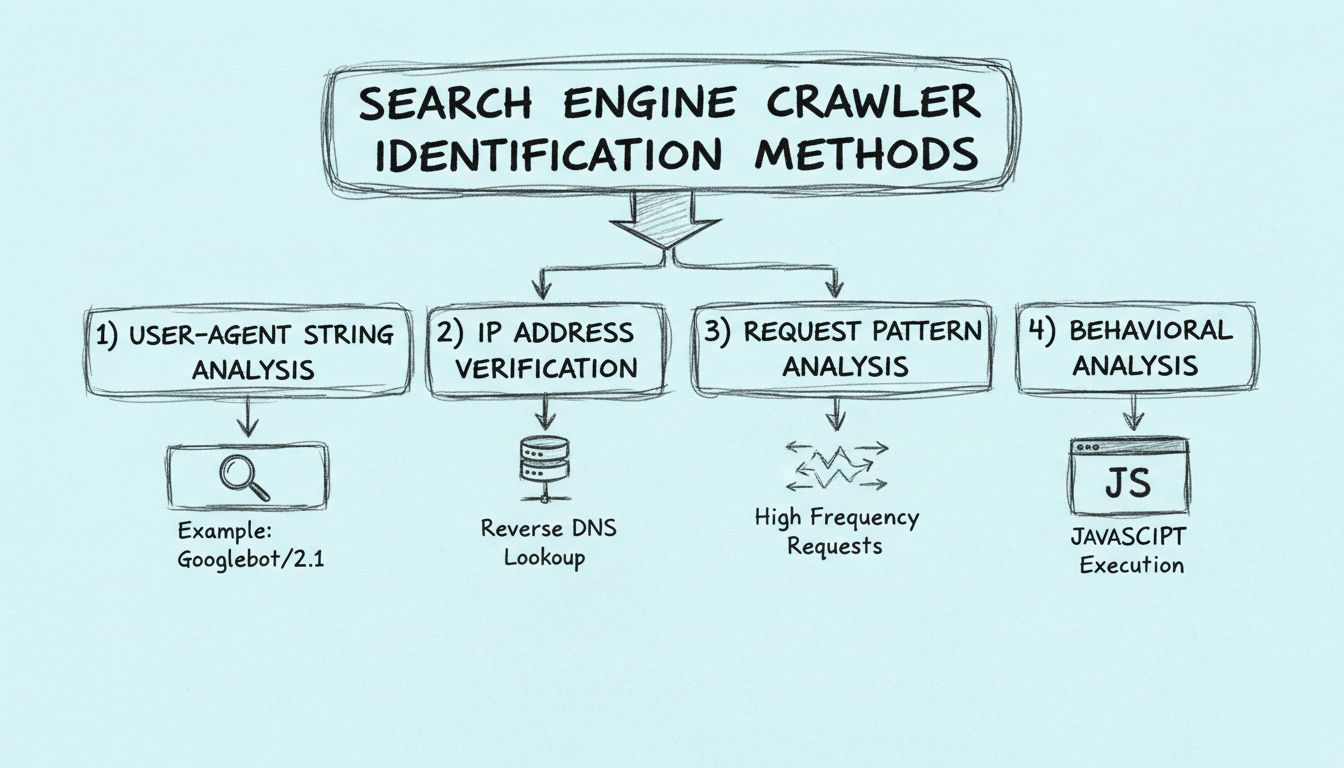

Zoekmachinecrawlers kunnen op verschillende manieren worden geïdentificeerd, onder andere door te kijken naar de user-agent string van de crawler, het IP-adres van de crawler te onderzoeken en patronen in de request headers te analyseren.

Webcrawlers werken door verzoeken naar websites te sturen en vervolgens de links op die websites te volgen naar andere websites. Ze houden bij welke pagina's ze bezoeken en welke links ze vinden, zodat ze het web kunnen indexeren en doorzoekbaar maken.

Webcrawlers worden spiders genoemd omdat ze door het web 'kruipen', waarbij ze links van de ene naar de andere pagina volgen.

Leer hoe begrip en optimalisatie voor crawlers de zichtbaarheid en ranking van je website in zoekmachines kunnen verbeteren.

Leer hoe webcrawlers werken, van seed-URL's tot indexering. Begrijp het technische proces, de verschillende typen crawlers, robots.txt-regels en hoe crawlers SE...

Spiders zijn bots die worden ingezet voor spamdoeleinden en kunnen grote problemen veroorzaken voor je bedrijf. Lees meer over ze in het artikel.

Leer hoe je zoekmachine crawlers kunt identificeren met behulp van user-agent strings, IP-adressen, aanvraagpatronen en gedragsanalyse. Essentiële gids voor web...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.